鄭宇君教授是一位跨領域的學者,大學階段讀的是臺大動物系,接著在政大新聞研究所完成碩士和博士的學業。早期也曾在玄奘大學大眾傳播學系任教,後來回到母校政大服務。

鄭教授笑著跟與會來賓們說:「我們跟AI的距離,事實上並沒有大家想得那麼遠。雖然它變化得很快,但其實都在我們的日常生活中可以看到它的蹤影。而我自己從生物科技的範疇跨到人文社會,現在又回去接觸一些AI的東西,覺得又有點回到那種理工的思維。」

鄭教授跟與會來賓分享自己的感觸,她說:「身為傳播學院的學生,要思考AI跟傳播的關聯是什麼?以及從AI到AIGC,看似跨了一小步,箇中可能卻是一個滿大的改變。特別是AI對於傳播跟人文社會的影響,以及對於未來的想像,值得各位博士生好好思考AI跟AIGC在教學跟研究上的各種應用。」

鄭教授表示,就傳播的角度來看,AI並不是一個今年才出現的議題。基本上大概從上個世紀開始,AI就已經存在了!只不過它所歷經的每一個時代變遷,都有不同的科技進展跟型態。

「在傳播領域,我們大概會從三個不同的角度來看AI:第一個角度,把它當作是一個工具,它可能就是協助我們生產傳播內容的工具。第二個角度,把它當作媒介,它是一種接收內容(就像我們看電視或者現在看Netflix)的這種載體。第三個角度,你會把它當作一個夥伴,特別是協作的夥伴。」鄭教授所提到的這三個角度,事實上都有很多學者正在進行討論。

鄭教授表示,就傳播的角度來看,AI並不是一個今年才出現的議題。基本上大概從上個世紀開始,AI就已經存在了!只不過它所歷經的每一個時代變遷,都有不同的科技進展跟型態。

「在傳播領域,我們大概會從三個不同的角度來看AI:第一個角度,把它當作是一個工具,它可能就是協助我們生產傳播內容的工具。第二個角度,把它當作媒介,它是一種接收內容(就像我們看電視或者現在看Netflix)的這種載體。第三個角度,你會把它當作一個夥伴,特別是協作的夥伴。」鄭教授所提到的這三個角度,事實上都有很多學者正在進行討論。

就AI今日的發展來看,她認為可能三個角度會同時並存:「特別是在智慧型手機問世之後,首先我們把它當工具。譬如說在新聞的產製上,大家就會看到它被當作是一個工具,可以快速地協助我們生產一些報導,特別是現在看到一些比較制式的報導,譬如說股市的漲跌啦、球賽結果等等。這些內容,都可以透過AI進行自動化生成的報導。好比澳洲的News Corp,該公司就用AI工具很快速地生產這些報導。」

鄭教授表示:「另外一個大家每天都常常在用,可是可能沒感覺的工具,其實後面都有AI的力量,就是我們現在看到各種美麗的照片,都不是原本的模樣。大家都會先修圖一下再上傳,所以我們常常會發現本人跟照片差很多⋯⋯話說回來,這也是因為現在大家都很習慣這種修圖的風氣了,甚至會把照片編修成綜漫、卡通或日系等不同的風格。我想,大家的手機裡,應該或多或少都有下載類似的App吧?基本上,這些軟體的背後也是靠AI的力量在運作哦!」

鄭教授表示:「另外一個大家每天都常常在用,可是可能沒感覺的工具,其實後面都有AI的力量,就是我們現在看到各種美麗的照片,都不是原本的模樣。大家都會先修圖一下再上傳,所以我們常常會發現本人跟照片差很多⋯⋯話說回來,這也是因為現在大家都很習慣這種修圖的風氣了,甚至會把照片編修成綜漫、卡通或日系等不同的風格。我想,大家的手機裡,應該或多或少都有下載類似的App吧?基本上,這些軟體的背後也是靠AI的力量在運作哦!」

另外說到AI作為媒介,鄭教授舉出了蘋果的Siri作為例子:「這種個人智慧助理,因為它長期跟你互動,所以基本上已經熟悉了你的聲音。今天如果換了一個人用的時候,基本上它就會抓不準字音。因為就語音輸入而言,它作為一種媒介⋯⋯當我今天透過Siri作為一個溝通的管道,現在有很多人懶得打字,通常都是用語音輸入,但有時候會出現一些奇怪的詞等等。」

「再來,AI作為夥伴。有些電影提到現代人常常比較孤單孤寂的時候,就會想找一個虛擬情人⋯⋯ 這個聽起來,有點像是電影中的橋段,但是現在的科技已經可以做到了!換句話說,AI不但可以成為你的虛擬情人,更可以作為你的工作夥伴,跟你緊密地互動。」

去年11月左右ChatGPT問世,當時就有一波AI熱。但是真正的黃金交叉,其實是在今年的一月與二月初。換句話說,那時候AI的搜尋熱度,開始高於media。

鄭教授指出,其中有很深的意涵:「也就是過去我們對media的需求,不管你要看內容,或者你要透過各種媒介的需求,在今天都可以被AI轉換。也許還不能說取代,也就是說原來的這些媒體裡面,某種程度都融入了一些AI在其中。」

換句話說,在AIGC出現之前,基本上AI本來已經常常出現在日常生活的各種媒介工具之中。但是從AI進展到AIGC,到底造成了什麼改變?

她提醒大家:「從AI到AIGC,我們都必須要去理解,這是一個疊加的關係,而不是取代的關係。換言之,原來AI的這些運作仍然在,但是多了AIGC在上面,那這兩個相加,它就會產生一些加乘的效果。我們今天主要講的AIGC,是除了原有的AI之外,比較重要的部分是它後面這個生成式的內容。當然也有人講這是『生成式AI』,其實範圍會比較更廣。英文是Generative AI,又叫GAI。」

「AIGC在這個脈絡下,特別我們身處在傳播領域,會把它視為是專業生產內容(PGC)和使用者生產內容(UGC)之後的第三代的內容創作方式。PGC就是早年我們講的專業人士所生產的內容,譬如說電視臺的電視新聞是由一群專業的新聞人員所生產,而UGC 一開始強調是每個人都可以生產,好比YouTube上的各種內容,約莫在2010年的時候最盛行。」

鄭教授也提到,現在的UGC也已經開始慢慢地走向專業化的路線。舉例來說,我們看到一些具有流量的網紅,像是志祺七七、阿滴英文,他們都不是一個人單打獨鬥,背後也是有一組團隊在操盤。所以相較於一般素人或同學所拍攝的這些影片,基本上你的流量是很難競爭過他們那些專業的網紅。

「所以,當UGC(使用者供應內容)開始慢慢專業化的時候,現在就進入了下一個世代。我們會認為說內容創作模式,會變成是AIGC。譬如說一般素人不可能比得上志祺七七、阿滴或者是唐綺陽,他們都會有一個專業的團隊幫忙打燈、寫腳本⋯⋯但是,在AIGC的紀元,又可以改變一種內容創作的形式。」

對傳播領域來說,鄭教授覺得這是一種新型態的內容創作方式,甚至是一種革命。AIGC有非常多種內容產製的型態,最基本的輸出就是文字。以ChatGPT為例,在自然語言處理的協助之下,可以運用文字來產生文字,接下來還可以用文字生產圖像、影音等等,好比大家所熟知的Midjourney或DALL·E 3。現在,也有AI可以產生音樂⋯⋯」

鄭教授指出,無論想要產出文字、圖像甚至建構一些3D的虛擬空間,生成式AI 都可以透過文字作為一個溝通媒介來達成。她談到在學術研究的範疇中,自己原本在做數據分析已經有十多年的歷史了,最早開始是從機器學習開始。

她坦言在機器學習的年代,整個過程比較辛苦:「譬如我跟政大新聞系的陳百齡老師在十多年前做莫拉克颱風的網路文本分析。當時,我請了一些人去標註這些文本的分類之後,接著就透過機器學習可以去幫忙標註。譬如說我們需要標註的一千筆資料,後來透過機器學習可以幫忙標註八千筆。這一千筆資料中,機器學習可以去分類出八千筆,聽起來很不錯!但是那時候遇到最大的困難是說,當這次莫拉克颱風做完,如果下次遇到另一個災難,或者我需要重新分類的時候,過往的那個知識是沒有辦法傳遞的。所以,當我遇到另外一個事件時,我又要重新去標註,這是非常耗人力的⋯⋯所以,機器學習在當時遇到的最大瓶頸就是說,如果你沒有事先標註資料,它是沒辦法學習的。換句話說,就是一定要先有人去標註,所以要仰賴大量的勞工。後來在深度學習跟類神經網路出現之後才逐漸改觀,不用標記也可以透過類神經網路的方式去學習得很好!又經過了一段時間的發展,才有今天所謂的『生成式AI』。」

鄭教授在這場講座中透過一個OpenAI官方的影片,跟大家講解了大型語言模型(LLM)的基本概念。她提到AI的普及,實際上對於傳播產業造成相當大的影響,而且不只是在新聞產製、行銷宣傳等範疇都可以幫很多忙。舉例來說,在自動化新聞跟自動化摘要的部分,AI的動作都非常快,甚至包括圖表製作。

如今,全球掀起了一波AI的熱潮,各行各業也紛紛推出了各種多元應用。誠然有很多事情AI都能夠勝任,即便是精準行銷也不在話下。鄭教授還特別舉了金曲歌手陳珊妮跟台灣人工智慧實驗室(Taiwan AI Labs)之前所進行的合作為例,透過影片跟大家分享陳珊妮發行了第一首由AI演唱的單曲的新聞事件。

仔細聆聽,發現AI不只把陳珊妮的獨特音色學得維肖維妙,就連換氣都學得超像!這首由陳珊妮和台灣人工智慧實驗室共同製作的單曲,至騙過許多專業音樂人的耳朵,顯見AI的能耐。

在AI發展熱議的當下,創作人的興奮與擔憂並行,陳珊妮期望透過這首歌,促動所有關心藝術創作的人思考——如果AI的時代必將到來,身為創作人該在意的或許不是「我們是否會被取代」,而是「我們還可以做些什麼」。

鄭教授表示:「我們從正向的角度來說,AI聊天機器人,它某種程度確實可以滿足某些人的情感需求。可是大家都知道,一旦談起戀愛,自然就有可能失戀⋯⋯萬一AI情人讓你失戀了之後,可能造成心理創傷,或是一些比較心理脆弱的人,後續要怎麼辦?我覺得接下來的時代,我們都可能必須去面對這個問題。但是,當然也不太可能因為這樣的緣故,就要去禁止AI的發展。所以,AIGC的發展,自然也會有一些負面的衝擊和影響。也就是說當科技進展到某個程度的時候,我相信這種AI聊天機器人是沒有辦法完全禁止的,它會跟著與時俱進,愈來愈客製化。」

鄭教授指出,就AI的負面影響來看,第一個就是倫理議題跟偏見,另外一個就是假訊息的傳播,還有就是用戶的隱私跟數據安全。另外,其實像是心理安全、心理健康,也是一個滿重要的議題。

「就像之前上李怡志老師的工作坊的時候,他曾示範在Midjourney下一些提示詞,就可產出很多圖像。後來,他可以用負向提示詞,也就是說我不要什麼⋯⋯所以,他就是下了一個『A girl in the bathroom』,生成左邊這樣的照片,然後第二次你再下『No future』的一個負向詞,就會出現這樣的照片。我相信大家一看就知道說,這張圖顯然種族偏見嘛,也就是說當這個girl是no future,沒有未來的時候,就會自動畫出一個黑人的小孩⋯⋯所以,我特別跟李老師要這張圖來當範例,這好像就意味我們剛剛講的,AI的訓練資料裡頭,也可能會有這樣子的倫理偏見。」

另外鄭教授也提到,對於AI生成的圖片跟影音內容的識別,如果要做假訊息跟事實查核的話,最大的困難就是在選舉季節所面臨的相關議題。

好比即將到來的2024年,大概全球很多國家都在選舉。那在新聞事件熱議的當下,這種快速生成的圖片很容易被分享,而且會不只有一張。鄭教授展示了一張之前網路上流傳的照片,上頭顯示美國前總統川普被逮捕了。但顯然這是AI生成的照片,並未真實發生。

鄭教授指出,就AI的負面影響來看,第一個就是倫理議題跟偏見,另外一個就是假訊息的傳播,還有就是用戶的隱私跟數據安全。另外,其實像是心理安全、心理健康,也是一個滿重要的議題。

「就像之前上李怡志老師的工作坊的時候,他曾示範在Midjourney下一些提示詞,就可產出很多圖像。後來,他可以用負向提示詞,也就是說我不要什麼⋯⋯所以,他就是下了一個『A girl in the bathroom』,生成左邊這樣的照片,然後第二次你再下『No future』的一個負向詞,就會出現這樣的照片。我相信大家一看就知道說,這張圖顯然種族偏見嘛,也就是說當這個girl是no future,沒有未來的時候,就會自動畫出一個黑人的小孩⋯⋯所以,我特別跟李老師要這張圖來當範例,這好像就意味我們剛剛講的,AI的訓練資料裡頭,也可能會有這樣子的倫理偏見。」

另外鄭教授也提到,對於AI生成的圖片跟影音內容的識別,如果要做假訊息跟事實查核的話,最大的困難就是在選舉季節所面臨的相關議題。

好比即將到來的2024年,大概全球很多國家都在選舉。那在新聞事件熱議的當下,這種快速生成的圖片很容易被分享,而且會不只有一張。鄭教授展示了一張之前網路上流傳的照片,上頭顯示美國前總統川普被逮捕了。但顯然這是AI生成的照片,並未真實發生。

「今天如果發生這樣的事情,你除非很認真去查核,其實基本上根本看不出它的破綻。所以,對於假訊息跟事實查核組織來說,無疑是挑戰重重。特別像是深偽技術(Deepfake),大概去年就已經了出現!我們看到某些影片中的人物會講一些話,然後你可能就無法辨識他的真假。」

好比有人偽造烏克蘭總統澤倫斯基在烏俄戰爭發表演說的影片,我們可以看到澤倫斯基被換臉,甚至流傳說他宣布投降⋯⋯一開始,大家發現這是一個假的影片,立刻把它下架,甚至驚動到澤倫斯基自己馬上澄清。

鄭教授提到,如果今天戰爭正在開打,即使知道這是一段假的影片,但是如果當事人沒有辦法立刻澄清的話,那假的訊息就會一直在網路上流傳。就算把影片從各種內容平臺下架,你也沒有辦法一網打盡!換句話說,這種東西只要一旦有了複本,就很容易大量複製跟流傳。

「特別在戰爭或選舉的時候,如果另外一方剛好因為某些狀況沒有辦法出來澄清,後果就很嚴重了。所以,我覺得生成式AI確實在假訊息的議題上會是非常大的問題。對於全球的新聞機構來說,無疑是一個很大的挑戰。我自己從個人的角度來說,面對生成式AI時代的來臨,以後生成內容愈快的時候,我們分享訊息就要愈慢。請大家不要一看到就立刻分享,我們就是要慢下來,先看看有沒有其他可信的組織出來證實這件事情?」

鄭教授提醒大家,未來如果看到可疑的訊息,建議要先找很多具有可信度的組織來求證。譬如說如果某個知名的新聞機構,可能還不只一家,甚至是兩三家都報了的話,這時你再去分享這則新聞,才會比較保險。

「當AI生成內容愈來愈快的時候,我們就要去做這件事。這可能是AI時代目前看到對社會造成最大的威脅。因為只要照片上面沒有標示是AI做的,就需要特別小心。當然,目前坊間也在討論說,是不是未來AI做的圖都要做標示?但目前沒有定論,所以要比對資訊的正確性,往往需要花很多時間。而人們看到一些似是而非的訊息,都會不自覺地去傳遞跟分享。所以我們在教媒體素養的時候,也都會提醒大家,愈是這樣的狀況之下,我們愈不要太快傳遞各種訊息。你要等到可信的新聞機構去做事實查核,甚至跟當事人相關的組織確認過這件事才發布。」

「AI的問世,的確會對我們社會造成很大的影響。但隨著ChatGPT開始可以聯網,以後可以上維基百科或很多網站去查資料,是有可能會改正過去的謬誤,但是沒有人能夠保證所有的東西都會改正。另外一個問題就是如果人們跟AI協作,譬如你跟他協作寫新聞稿,如果出了問題是誰要負責?舉例來說,目前有些AIGC軟體,就禁止生成現任政治人物的圖像,這也是避免一些可能出現的爭端。」鄭教授提醒大家,這些議題未來可能層出不窮,都值得思索。

鄭教授指出,伴隨AI時代的來臨,我們已經無法避免很多假訊息的流傳。所以,要怎麼樣找到一個值得信任的訊息來源就顯得格外重要。另外,對於專業的新聞機構來說,要怎麼樣去做事實的查核查證,也是非常重要的一件事。

最後,鄭教授提到AI對教育的影響:「ChatGPT可以作為老師、學習同伴或是助教,它特別擅長那些原本需要花時間記憶跟背誦的科目。譬如說你現在問它明朝的皇帝誰誰誰,其實它都可以回答得出來。另外像是寫作跟寫程式,也是它的強項。好比有些學生在學寫程式,譬如說他本來學的是R,他今天如果要學Python,基本上邏輯是一樣的。這時,他可以直接叫ChatGPT幫他把R語言的程式寫成Python。但是,我覺得這個前提是學生還是要先有一些基本的運算思維跟邏輯思維。有了這些先備知識,當你要從R轉成Python,就可以透過ChatGPT幫忙轉譯或改寫。」

鄭教授表示,只要頭腦想得夠清楚,即便原本你的程式架構本來沒有很完整,都可以透過ChatGPT來幫你修得更完整。

「我覺得有一個滿好的地方,就是過去可能有些老師會怕學生回家的作業都是要AI去幫忙寫答案。好比如果老師要學生交作業是做摘要的話,可能大家摘出來的東西都很像!所以,老師就必須要重新設計教學方式。好比我曾看一位老師,就要他的學生不可以叫AI給你答案,而是讓AI設計問題來考學生!所以,我們可以換個角度來思考教學設計,結合AI的知識體系。AI的知識體系是有下有上的,好處是它的資料夠廣,缺點就是說對於某一些知識領域來說,它可能是缺乏資料的,它的回答可能是有局限性的。所以,我們必須要去理解,怎麼樣把人類知識的傳授方式跟AI知識的傳授方式相互結合,以及我們該如何學習使用它的語言?也就是學習所謂的提示工程。」

鄭教授指出,目前有一些事情還是AI沒辦法做的。好比叫AI寫作文,它肯定會寫,但這篇作文的品質好壞,還是需要人的判讀,資料是不是正確,也是需要查核。

鄭教授表示,只要頭腦想得夠清楚,即便原本你的程式架構本來沒有很完整,都可以透過ChatGPT來幫你修得更完整。

「我覺得有一個滿好的地方,就是過去可能有些老師會怕學生回家的作業都是要AI去幫忙寫答案。好比如果老師要學生交作業是做摘要的話,可能大家摘出來的東西都很像!所以,老師就必須要重新設計教學方式。好比我曾看一位老師,就要他的學生不可以叫AI給你答案,而是讓AI設計問題來考學生!所以,我們可以換個角度來思考教學設計,結合AI的知識體系。AI的知識體系是有下有上的,好處是它的資料夠廣,缺點就是說對於某一些知識領域來說,它可能是缺乏資料的,它的回答可能是有局限性的。所以,我們必須要去理解,怎麼樣把人類知識的傳授方式跟AI知識的傳授方式相互結合,以及我們該如何學習使用它的語言?也就是學習所謂的提示工程。」

鄭教授指出,目前有一些事情還是AI沒辦法做的。好比叫AI寫作文,它肯定會寫,但這篇作文的品質好壞,還是需要人的判讀,資料是不是正確,也是需要查核。

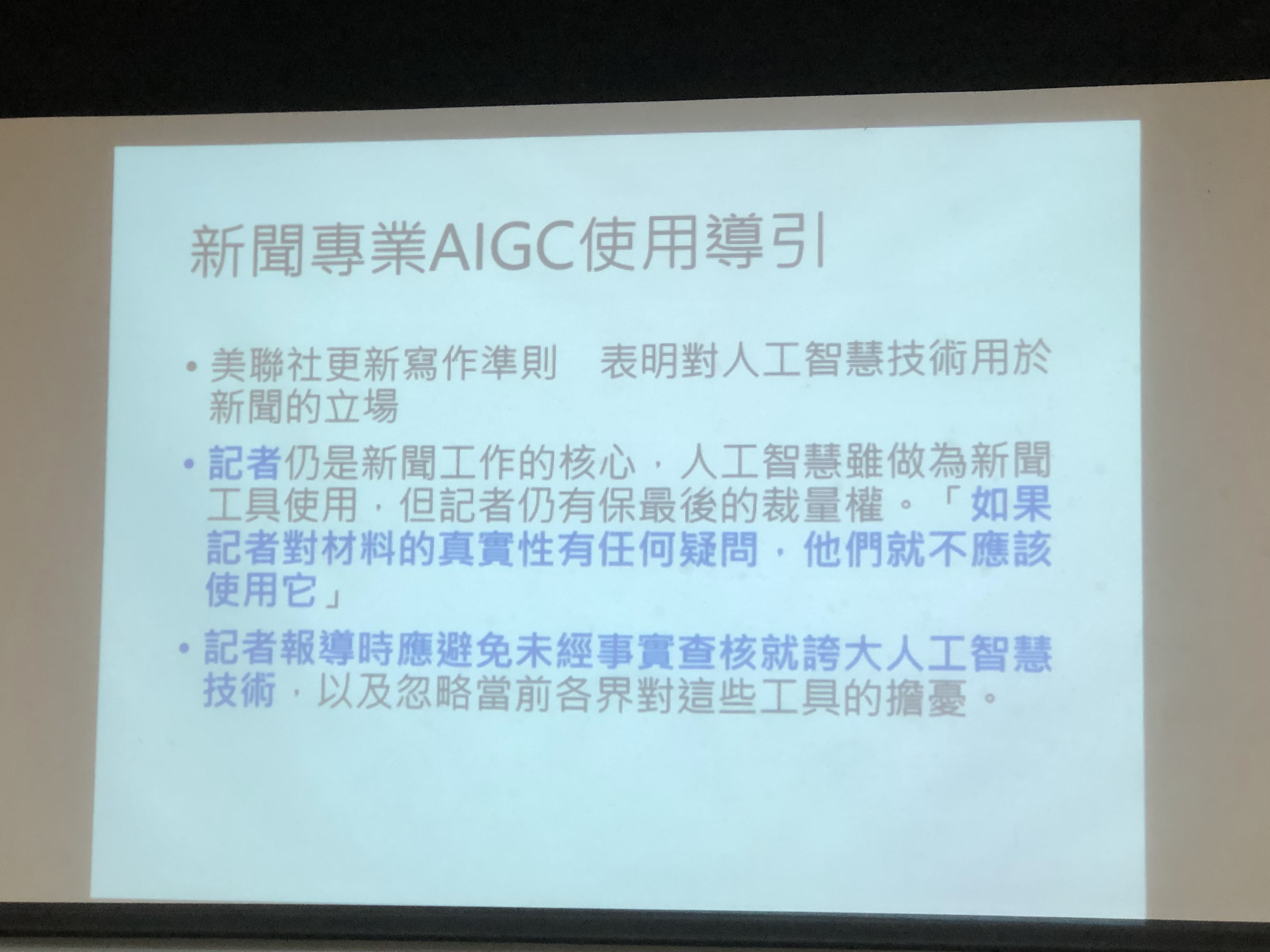

身為AI使用者,鄭教授建議大家要有一個當責的概念:「就是說我今天用了AI做任何事,學習也好、或者是工作也好,如果今天寫錯了,都還是要有人來負責。譬如以美聯社來說,他們在AIGC的使用上就有明確的指引。所有的新聞工作對AI的態度就是,記者還是新聞工作的核心,所以你可以把AI當工具來使用,但是記者要保留最終的裁量權。意思是如果你覺得它講得有問題,那麼我們就不應該使用。」

她語重心長地說:「另外,我們也無需過於誇大AI技術,因為AI進展的非常快,真的世界上敢說自己是AI專家的人應該沒幾個。也因為真的進展非常快,所以請不要過於誇大它,也必須要了解它可能帶來的隱憂。」

整個AI對人文社會的影響,鄭教授把它分成三圈來看:「它可以從內到外,就會有非常非常多新的研究議題出現。那對內圈,我覺得就是基本上AI出現就是一種新的Cyborg(Cybernetic Organism)。譬如說我們講手機的出現,就是一種Cyborg的現象。但未來的AI,甚至都沒有一個類似手機這樣一個小小的東西別在身上。當這種新的Cyborg出現的時候,你會重新去問說:『AI的本質是什麼?』,要去思考人的認知跟思維如何因為它而改變?」

她語重心長地說:「另外,我們也無需過於誇大AI技術,因為AI進展的非常快,真的世界上敢說自己是AI專家的人應該沒幾個。也因為真的進展非常快,所以請不要過於誇大它,也必須要了解它可能帶來的隱憂。」

整個AI對人文社會的影響,鄭教授把它分成三圈來看:「它可以從內到外,就會有非常非常多新的研究議題出現。那對內圈,我覺得就是基本上AI出現就是一種新的Cyborg(Cybernetic Organism)。譬如說我們講手機的出現,就是一種Cyborg的現象。但未來的AI,甚至都沒有一個類似手機這樣一個小小的東西別在身上。當這種新的Cyborg出現的時候,你會重新去問說:『AI的本質是什麼?』,要去思考人的認知跟思維如何因為它而改變?」

她提到,人跟AI如何協力,大概會是傳播領域常常遇到的問題。一種是AI與溝通,這裡又可以分成有目的性跟無意識兩種,有目的性就像譬如說我要跟AI合寫文章,而無意識的部分也可能會有很多創新,譬如說AI、VR的融合的可能等等。

鄭教授從AI到AIGC的整個演變的過程,提出她的宏觀看法。總結這場講座的分享,她認為AI的應運而生,未來不只是牽動到科技文明跟社會環境的整體互動,我們都可能會看到一些新的協力方式出現,對於整個社會的衝擊和影響自然是巨大的。而AI目前基本上還沒有辦法解決人類社會真善美的問題,這些也都是我們要實事求是的部分。

對AI創作的內容或藝術來說,到底有沒有失真,是不是真的美?鄭教授覺得這個部分,還都需要人們的社群共識。但是,AI顯然會觸及到現實社會中有關真實跟倫理的層面,另外在治理、教育跟整個制度、法規的部分,包括智慧財產權等議題,也就是AI會對人文社會造成的影響,都需要我們有一番嶄新的思考跟規範。

鄭教授從AI到AIGC的整個演變的過程,提出她的宏觀看法。總結這場講座的分享,她認為AI的應運而生,未來不只是牽動到科技文明跟社會環境的整體互動,我們都可能會看到一些新的協力方式出現,對於整個社會的衝擊和影響自然是巨大的。而AI目前基本上還沒有辦法解決人類社會真善美的問題,這些也都是我們要實事求是的部分。

對AI創作的內容或藝術來說,到底有沒有失真,是不是真的美?鄭教授覺得這個部分,還都需要人們的社群共識。但是,AI顯然會觸及到現實社會中有關真實跟倫理的層面,另外在治理、教育跟整個制度、法規的部分,包括智慧財產權等議題,也就是AI會對人文社會造成的影響,都需要我們有一番嶄新的思考跟規範。

留言